安装 Perplexica 主要有两种方法-有 Docker,没有 Docker。强烈推荐使用 Docker。

-

确保 Docker 已安装并在您的系统上运行。

-

克隆 Perplexica 存储库:

git clone https://github.com/ItzCrazyKns/Perplexica.git

-

克隆之后,导航到包含项目文件的目录。

-

将 sample.config.toml 文件重命名为 config.toml:

-

OPENAI: 你的 OpenAI API 密钥。如果你想使用 OpenAI 的模型,你只需要填写这个。

-

你的奥拉马 API 网址。你应该以 http://host.docker.internal:port_number 的身份输入。如果您在端口11434上安装了 Ollama,请使用 http://host.docker.internal:11434。对于其他端口,进行相应的调整。如果你想使用奥拉马的模型而不是 OpenAI 的模型,你需要填写这个。

-

GROQ: 你的 GROQ API 密钥。如果你想使用 GROQ 的托管模型,你只需要填写这个

注意: 您可以在设置对话框中启动 Perplexica 后更改这些设置。

-

SIMILARITY _ MEASURE: 要使用的相似度量(这是默认填充的; 如果不确定,可以保持原样)

-

-

确保您在包含 docker-compose. yaml 文件的目录中,然后执行:

docker compose up -d

-

等待几分钟安装完成,你可以在浏览器的 http://localhost:3000访问 Perplexica。

注意: 集装箱建成后,你可以从 Perplexica 直接从 Docker 出发,而不必开设码头。

特征

- Local LLM: 您可以使用本地 LLM,比如 Llama3和 Mixtral。

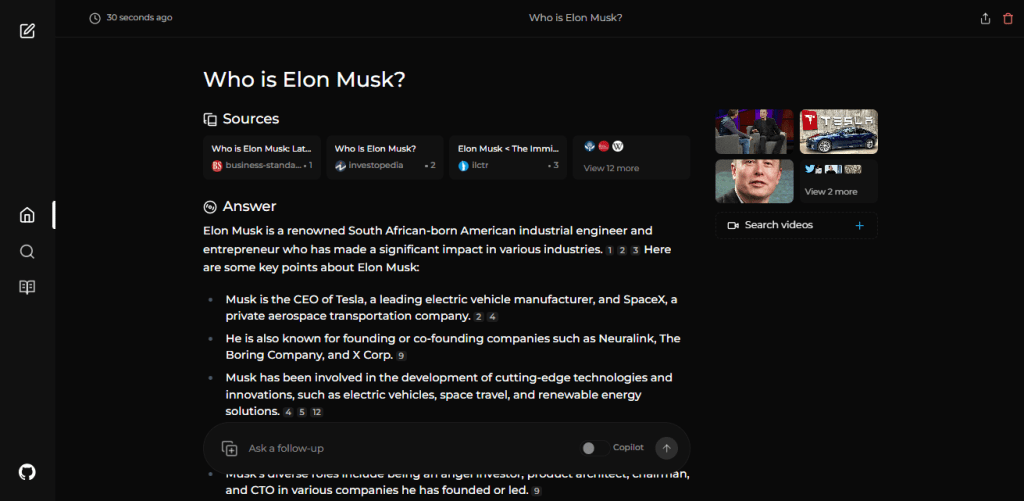

- 两种主要模式:

- Copilot 模式: (正在开发)通过生成不同的查询来寻找更多相关的互联网资源,从而提高搜索效率。就像普通搜索,而不是仅仅使用 SearxNG 的上下文,它访问顶部匹配,并试图从页面直接找到用户查询的相关资源。

- 正常模式: 处理您的查询和执行网络搜索。

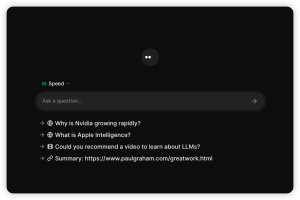

- 焦点模式: 特殊模式更好地回答特定类型的问题。困惑目前有6个焦点模式:

- 所有模式: 搜索整个网络,以找到最好的结果。

- 编写助手模式: 有助于编写不需要搜索网页的任务。

- 学术搜索模式: 查找文章和论文,理想的学术研究。

- YouTube 搜索模式: 根据搜索查询查找 YouTube 视频。

- Wolfram Alpha 搜索模式: 使用 Wolfram Alpha 回答需要计算或数据分析的查询。

- Reddit 搜索模式: 搜索与查询相关的讨论和意见。

- 当前信息: 一些搜索工具可能会给你过时的信息,因为他们使用的数据从爬行机器人,并转换成嵌入式和存储在一个索引。与它们不同的是,Perplexica 使用 SearxNG,这是一个元搜索引擎,可以获得结果,重新排序,并从中获得最相关的信息源,确保您总是能够获得最新的信息,而不需要每天更新数据。

它还有很多功能,比如图像和视频搜索,一些计划中的功能将在下一个功能中提到。

暂无评论内容