Linly-Dubbing是什么

![图片[1]-Linly-Dubbing:智能视频多语言AI配音/翻译工具-游读社](https://github.com/Kedreamix/Linly-Dubbing/raw/main/docs/linly_logo.png)

Linly-Dubbing 是一个受 YouDub-webui 启发而进一步扩展和优化的智能多语言人工智能配音和翻译工具。我们的目标是通过整合 Linly-Talker 的数字化人类假唱技术,提供多样化和高质量的配音选择,创造一个更自然的多语言视频体验。

Linly-Dubbing 利用尖端的人工智能技术,为多语言配音的自然性和准确性设定了新的标准,使其成为国际教育、全球内容本地化等领域的理想选择。它帮助团队扩展他们的影响范围,并在全球范围内分享高质量的内容。

主要功能包括:

- 多语言支持: 提供中文和其他多种语言的配音和字幕翻译,以满足全球需求。

- 人工智能语音识别: 采用先进的人工智能进行精确的语音文本转换和讲话者识别识别。

- 大语言模式翻译: 采用 GPT 等主流语言模式进行快速、准确的翻译,确保专业质量。

- 人工智能语音克隆: 利用最先进的语音克隆技术,生成与原始视频语调和情感非常匹配的语音。

- 数字人类假唱同步技术: 同步配音与视频视觉,增强现实主义和互动。

- 灵活上传和翻译: 用户可以上传视频,选择翻译语言和标准,确保个性化和灵活性。

- 定期更新: 不断引进最新的模型,保持配音和翻译技术的领先地位。

我们的使命是提供无缝,高质量的多语言配音和翻译服务,赋予内容创作者和企业在全球市场蓬勃发展。

Linly-Dubbing主要特点

– AI智能语音识别:先进的语音到文本转换和说话者识别技术。

– 大型语言模型翻译:使用领先的语言模型进行快速、准确的翻译。

– AI声音克隆:生成与原配音高度相似的语音,保持情感和语调的连贯性。

– 数字人对口型技术:配音与视频高度契合,提升真实性。

– 灵活上传与翻译:用户可自主选择翻译语言和标准。

– 定期更新:持续引入最新模型,保持领先地位。

Linly-Dubbing 如何使用

安装和使用指南

测试环境

本指南适用于以下测试环境:

- Python 3.10,PyTorch 2.3.1,CUDA 12.1

- Python 3.10,PyTorch 2.3.1,CUDA 11.8

按照以下步骤安装和配置 Linly-Dubbing。

注意

Colab 脚本也可用于在线体验: Linly-Dubbing Colab。

1. 克隆储存库

首先,将 Linly-Dubbing 存储库克隆到本地计算机并初始化子模块。

# Clone the project to your local machine

git clone https://github.com/Kedreamix/Linly-Dubbing.git --depth 1

# Navigate to the project directory

cd Linly-Dubbing

# Initialize and update submodules like CosyVoice

git submodule update --init --recursive

2. 安装依赖项

在继续之前,请创建一个新的 Python 环境并安装所需的依赖项。

# Create a conda environment named 'linly_dubbing' and specify Python version 3.10

conda create -n linly_dubbing python=3.10 -y

# Activate the newly created environment

conda activate linly_dubbing

# Navigate to the project directory

cd Linly-Dubbing/

# Install the ffmpeg tool

# Install ffmpeg using conda

conda install ffmpeg==7.0.2 -c conda-forge

# Install ffmpeg using a domestic mirror

conda install ffmpeg==7.0.2 -c https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

# Upgrade pip to the latest version

python -m pip install --upgrade pip

# Change the PyPI source to speed up package downloads

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

根据 CUDA 版本,使用以下命令安装 PyTorch 和相关库:

# For CUDA 11.8

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu118

# For CUDA 12.1

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu121

如果您喜欢通过 conda 安装 PyTorch,可以使用以下命令:

# For CUDA 11.8

conda install pytorch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 pytorch-cuda=11.8 -c pytorch -c nvidia

# For CUDA 12.1

conda install pytorch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 pytorch-cuda=12.1 -c pytorch -c nvidia

注意

安装过程非常缓慢。

接下来,安装剩余的项目依赖项:

# Install the required Python packages for the project

# pynini is required by WeTextProcessing, so use conda to install it as it works across all platforms.

conda install -y pynini==2.1.5 -c conda-forge

# -c https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

pip install -r requirements.txt

# Install dependencies for submodules

pip install -r requirements_module.txt

小费

如果在安装过程中遇到“无法加载库 libcudnn _ ops _ infer. so.8”的错误,请按照以下步骤进行修复:

# Set LD_LIBRARY_PATH to include the correct cuDNN library path

export LD_LIBRARY_PATH=`python3 -c 'import os; import torch; print(os.path.dirname(os.path.dirname(torch.__file__)) +"/nvidia/cudnn/lib")'`:$LD_LIBRARY_PATH

3. 配置环境变量

在运行程序之前,您需要配置必要的环境变量。在项目的根目录中,创建一个。通过重命名 env.example 并填充以下变量来实现 env 文件:

- OPENAI _ API _ KEY: 您的 OpenAI API 密钥,通常格式为 sk-xxx。

- MODEL _ NAME: 您正在使用的模型的名称,例如 gpt-4或 gpt-3.5-turbo。

- OPENAI _ API _ BASE: 如果您正在使用自托管的 OpenAI 模型,请在这里提供相应的 API 基 URL。

- HF _ TOKEN: 您的拥抱面 API 令牌,用于访问和下载模型。

- HF _ ENDPOINT: 一个自定义的拥抱面端点,如果在模型下载中遇到问题,可以指定该端点。

- APPID 和 ACCESS _ TOKEN: 使用字节跳动 TTS 引擎的凭据。

- BAIDU _ API _ KEY 和 BAIDU _ secret _ KEY: 用于百度的 Ernie Bot API。

注意

在大多数情况下,您只需要配置 MODEL _ NAME 和 HF _ TOKEN。

默认情况下,MODEL _ NAME 设置为 Qwen/Qwen1.5-4b-Chat,因此不需要配置 OPENAI _ API _ KEY。

小费

由于大型模型的性能在正常情况下可能会受到限制,因此建议使用更大的模型或更好的 API。我个人建议选择 OpenAI 的 API。如果担心成本问题,你可以试试百度的 Ernie Bot API,它提供免费的 API 访问。只需申请 API 并将其添加到您的环境变量中: https://console.bce.baidu.com/qianfan/ais/console/applicationconsole/application/v1。

你可以从拥抱脸得到你的 HF _ TOKEN。如果您希望使用扬声器分离功能,请确保请求访问 pyannote/扬声器日志化 -3.1。否则,您可以选择不启用此特性。

4. 运行应用程序

在启动应用程序之前,运行以下命令自动下载所需的型号(包括 Qwen、 XTTSv2和 Speed-Whiser-big-v3) :

# For Linux

bash scripts/download_models.sh

# For Windows

python scripts/modelscope_download.py

# Download the wav2vec2_fairseq_base_ls960_asr_ls960.pth file and place it in the models/ASR/whisper folder

wget -nc https://download.pytorch.org/torchaudio/models/wav2vec2_fairseq_base_ls960_asr_ls960.pth \

-O models/ASR/whisper/wav2vec2_fairseq_base_ls960_asr_ls960.pth

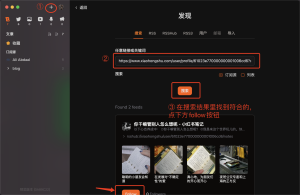

下载完成后,使用以下命令启动 WebUI 界面:

python webui.py

启动后,你会看到一个类似下面这样的界面,你可以打开 http://127.0.0.1:6006浏览应用程序:

详细的特点和技术细节

自动视频下载

Yt-dlp 是一个强大的开源命令行工具,用于从 YouTube 和其他网站下载视频和音频。该工具提供了广泛的参数选项,允许用户根据自己的需要自定义下载行为。无论是选择特定的格式、分辨率还是提取音频,yt-dlp 都提供了灵活的解决方案。它还支持广泛的后处理特性,例如自动添加元数据和重命名文件。有关参数和用法的更多详细信息,请参考 yt-dlp 官方存储库。

声音分离

Demucs

Demucs 是 Facebook 研究小组开发的一种先进的声音分离模型,旨在将不同的声源从混合音频中分离出来。尽管它的架构很简单,但 Demucs 功能强大,可以隔离乐器、声音和背景噪音,使用户更容易进行后期处理和编辑。其用户友好的设计使其成为许多音频处理应用程序的首选工具,包括音乐制作和电影后期制作。更多信息可以在 Demucs 项目页面上找到。

UVR5

UVR5(终极去声器)是声乐和伴奏分离的最佳工具之一。它擅长于生成高质量的伴奏和声音提取,表现优于 RX9、 RipX 和 SpectraLayers9等工具。提取的伴奏几乎没有区别于原来的立体声轨道,并且 UVR5是开源和免费的。查找源代码: https://github.com/anjok07/ultimatevocalremovergui。

网络用户界面参考资料: https://github.com/rvc-boss/gpt-sovits/tree/main/tools/uvr5

型号重量参考: https://huggingface.co/lj1995/voiceconversionwebui/tree/main/uvr5_weights

人工智能语音识别

低语者 X

WhisperX 是 OpenAI 的 Whisper 语音识别系统的扩展,专门为视频生成和对齐字幕而设计。与传统的语音识别系统不同,WhisperX 不仅能够准确地将语音内容转录成文本,而且还能够将其与视频帧对齐,从而生成带时间戳的字幕文件。这种精确的对齐使视频编辑和字幕生成更加有效和直观。WhisperX 还支持多扬声器识别,为更丰富、更容易理解的字幕提供详细的扬声器信息。

FunASR

FunASR 是一个全面的语音识别工具包,提供广泛的语音处理功能,包括自动语音识别(ASR)、语音活性检测(VAD)、标点恢复、语言建模、说话人验证、说话人分离和多说话人对话识别。FunASR 特别针对中文语音进行了优化,并提供了经过预先训练的模型和易于微调的界面。它是语音识别领域的一个重要工具,广泛应用于语音助手、字幕自动生成等领域。有关更多信息,请访问 FunASR 项目。

大语言模型翻译

OpenAI API

Linly-Dubbing 使用 OpenAI 的大型语言模型,如 GPT-4和 GPT-3.5-turbo,通过 API 执行高质量的翻译。OpenAI 的模型以其自然语言理解和高精度文本生成功能而闻名,这些功能通常用于对话生成和文本分析等任务。您可以在 OpenAI 官方文档中找到关于模型和用法的更多细节。

奎恩

Qwen 是一个支持多语言翻译的本地化大语言模型。尽管其性能可能无法与 OpenAI 的顶级模式相媲美,但其开源特性和本地执行使其成为一种性价比高的选择。Qwen 能够处理跨多种语言的文本翻译,并且是一个强大的开源替代品。更多细节可以在 Qwen 项目页面上找到。

谷歌翻译

作为翻译功能的补充,Linly-Dubbing 还集成了 Google 翻译。谷歌翻译提供了广泛的语言支持和良好的翻译质量,使它适合快速获得近似翻译。

人工智能语音合成

边缘 TTS

Edge TTS 是微软提供的一种高质量的文本到语音转换服务。它支持多种语言和语音风格,能够生成自然流畅的语音输出。使用 Edge TTS,Linly-Dubbing 可以从文本中生成高质量的语音,使内容更加生动和易懂。有关详细信息,请参阅 EdgeTTS 官方文档。

XTTS

Coqui XtTS 是一个先进的深度学习文本到语音工具包,专注于语音克隆和多语言语音合成。XTTS 可以通过使用简短的音频片段实现语音克隆,并生成逼真的语音输出。它提供了各种预先培训的模型和开发工具,支持培训和新模型的微调。用户可以在 Hugging Face 上在线探索 XTTS 的功能,或者访问官方的 GitHub 存储库了解更多技术细节。

- 试试在线 XTTS: 拥抱脸

- 官方 GitHub 存储库: Coqui TTS

舒适之声

CosyVoice 是一个多语言语音理解和合成模型,由阿里巴巴同义实验室开发,支持汉语、英语、日语、广东话、韩语等。CosyVoice 接受了超过15万小时的语音数据培训,能够进行高质量的语音合成和跨语言语音克隆。它擅长产生自然和连贯的语音跨语言,支持一次性声音克隆,只需要3至10秒的原始音频生成一个类似的声音。欲了解更多信息和模型细节,请访问 CosyVoice 项目。

主要特点:

- 多语言支持: 处理各种语言的语音合成任务。

- 多风格语音合成: 通过命令控制情绪和语调。

- 流推理支持: 未来的计划包括实时流推理支持。

GPT-SoVITS

由于开源社区的贡献,AI 语音合成也受益于开源语音克隆模型 GPT-soVITS。GPT 是一种基于转换器的自然语言处理模型,具有很强的文本生成能力,而 SoVITS 是一种基于深度学习的语音转换技术,能够将一个人的语音转换为另一个人的语音。通过这两种技术的结合,GPT-SoVITS 可以生成与给定文本内容相匹配的高度逼真的语音。

该计划的主要 https://github.com/rvc-boss/gpt-sovits 包括:

- 零拍文本到语音(TTS) : 输入一个5秒钟的语音样本,体验即时文本到语音转换。

- 很少拍摄的 TTS: 微调模型只有1分钟的训练数据,以提高声音的相似性和真实性。

- 跨语言支持: 不同于训练数据集的跨语言推理,目前支持英语、日语和中文。

- WebUI 工具: 集成工具包括语音伴随分离、自动数据集分离、中文自动语音识别(ASR)和文本注释,以帮助初学者创建训练数据集和 GPT/SoVITS 模型。

视频处理

在视频处理方面,Linly-Dubbing 提供了健壮的功能支持。用户可以很容易地添加字幕,插入背景音乐,调整背景音量,并修改整体播放速度。有了这些功能,用户可以自定义视频内容,使其更具吸引力和个性化。

数字化人体假唱技术

受 Linly-Talker 的启发,这个项目专注于数字化人类假唱技术。通过结合先进的计算机视觉和语音识别技术,Linly-Talker 允许数字字符的嘴唇运动精确匹配语音,实现高度自然的同步。该技术不仅适用于动画人物,而且还可以用于虚拟演示者或教学视频中的教育工作者等场景。Linly-Talker 通过准确的假唱和生动的面部表情来增强数字角色的表演,为观众提供更加身临其境的体验。这种先进的数字化人类假唱技术显著提高了视频内容的专业性和观看体验。有关详情,请参阅 https://github.com/kedreamix/linly-talker。

驾照

注意

使用此工具时,请遵守相关法律,包括版权法、数据保护法和隐私法。未经原作者和/或权利持有者许可,不得使用此工具。

暂无评论内容